Die Förderung des neuen Öls – ein Projektbericht

Daten bergen vielfältige und essenzielle Informationen, jedoch kommt es bei der Datenimplementierung und -analyse im Unternehmen häufig zu Unklarheiten. Worauf bei der Datennutzung sowie -verarbeitung geachtet werden muss und welche Prozesse sich bewährt haben, zeigen Einblicke in ein aktuelles Kundenprojekt.

"Daten sind das neue Öl", doch solange diese unraffiniert in den Systemen schlummern, sind sie gleichzeitig relativ wertlos. Dem gegenüber steht eine Vielzahl an Fragestellungen in den verschiedensten Fachbereichen von Unternehmen, die mit diesen Daten beantwortet werden können. Eine solche Problematik beschäftigte auch die ENGIE Deutschland, die u.a. als Errichter und Betreiber von dezentralen Versorgungslösungen deutschlandweit aktiv ist. Im Rahmen des gemeinsamen Projekts stand vor allem die Herausforderung im Raum, zu ergründen, was ein Unternehmen benötigt, um Data Analytics aufzubauen. Dazu wurde eine konkrete fachliche Fragestellung als „Pilotprojekt“ formuliert.

Das Fachteam Analytik & IT der Energieforen hat die ENGIE bei der Beantwortung begleitet, mit dem zusätzlichen Ziel, die Mitarbeitenden im Bereich Application Management der ENGIE zu befähigen, Datenanalysen zukünftig auch eigenständig durchführen zu können. Weiterhin gab es nach erfolgreichem Projektabschluss einen eintägigen Hands-on-Workshop, in dem seitens des Fachteams direktes Anwendungs-Know-how vermittelt wurde.

Das Projekt

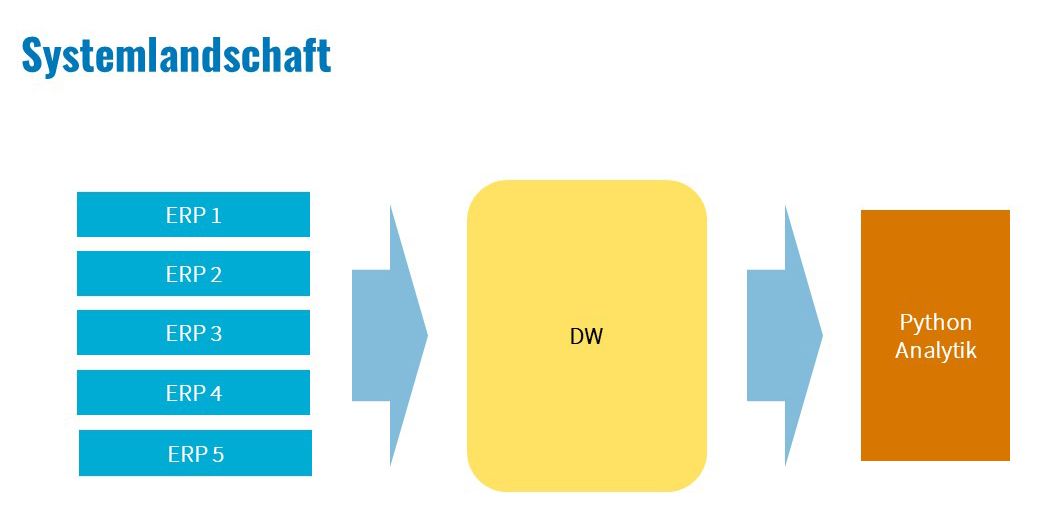

Daten verbergen sich oftmals in den verschiedensten Systemen, die für die Abbildung unterschiedlicher Prozesse im Geschäftsalltag genutzt werden, beispielsweise ERP- oder EDM-Systeme. Eine große Herausforderung besteht dabei häufig darin, diese Daten aus den entsprechenden Systemen zu extrahieren und nutzbar zu machen. Durch die strategische Einführung eines Data Warehouses (DW) war die ENGIE zu Projektbeginn bereits optimal aufgestellt, um sich direkt auf das eigentliche Ziel, nämlich die Beantwortung der folgenden Fragen, stürzen zu können: Welche Daten benötigen wir? Wie gut ist die Datenqualität? Wie hochwertig ist die Datendichte? Gibt es Inkonsistenzen oder Beziehungen zu anderen Datenquellen?

Um sich diesen grundlegenden Problematiken zu nähern, galt es zunächst, ein gemeinsames Bild der im DW zusammengetragenen Datenstrukturen zu erarbeiten (Abb. 1) und zu sortieren, welche Daten aus den umfangreichen Datentabellen für die Beantwortung der Fragestellungen überhaupt relevant sind sowie die Prozesse hinter den Daten aufzuschlüsseln. Nur so kann gewährleistet werden, dass Daten final richtig interpretiert werden können.

Abb. 1: Datenfluss aus den Systemen über das zentrale DW zum Analyse-Server

Die Datenbasis für die durchgeführten Analysen bestand aus Daten von unterschiedlichen ERP-Systemen. Diverse Applikationen und Datentabellen wurden analysiert und hinsichtlich ihrer Qualität und Dichte verifiziert. Weiterhin fand ein regelmäßiger, intensiver Austausch zur fachlichen Interpretation der Daten statt.

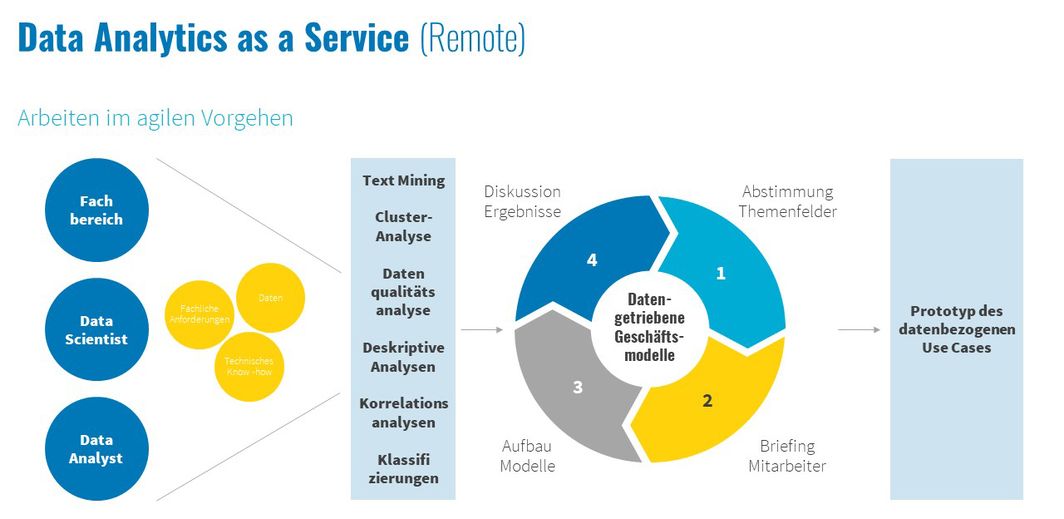

Bewährt hat sich in diesem Zusammenhang ein iteratives Vorgehen und ein enger Austausch des Fachbereichs und der Datenanalystinnen und Datenanalysten in einem mindestens wöchentlichen Zyklus.

Abb. 2: Zusammenarbeit als iterativer Prozess

Schrittweise wurden nunmehr die relevanten Daten zusammengeführt, hinsichtlich ihrer Qualität bewertet und schließlich für eine explorative Analyse mit Blick auf die Zielfragen herangezogen. Hilfreich war hierbei, die übergeordneten Zielfragen nochmals in mehrere Detailfragen zu reduzieren und sich anhand dieser dem Wesentlichen zu nähern. Dafür wurde nach Aufbereitung sowie Bereinigung der Daten eine technische sowie kaufmännische Analyse durchgeführt, wobei verschiedene Stammdateneigenschaften berücksichtigt wurden. So konnte die vereinbarte Fragestellung aus unterschiedlichen Blickwinkeln bewertet und eine klare Tendenz für eine Fachentscheidung dargestellt werden.

Neben der eigentlichen Beantwortung der pilotierten Fragestellung war es essenziell, zu identifizieren, was man als Unternehmen konkret benötigt, um Data Analytics zu implementieren. Zunächst wurde dafür eine Entscheidungsgrundlage für das Management-Team erarbeitet. Dabei wurden strukturelle, prozessuale, personelle sowie kulturelle Aspekte berücksichtigt. Darüber hinaus erfolgte eine Reflektion mit den derzeitigen IST-Werten mit einer daraus resultierenden Empfehlung.

Der Werkzeugkasten für Data Analytics

Zum Projektabschluss fand schließlich ein eintägiger Hands-on-Workshop statt, in dem das Fachteam der Energieforen einen Leitfaden und Werkzeugkasten für die Datenanalyse mittels der Programmiersprache Python anhand der spezifischen Projektdaten vorgestellt hat.

Dabei lehnen sich die Themen sehr eng an den Cross-Industry Standard for Data Mining an. Ziel des Workshops war es aber nicht nur, die graue Theorie zu vermitteln, sondern ganz konkrete Praxistipps anhand der projektspezifischen Daten mitzugeben. Dabei kann ein eintägiger Workshop aber natürlich nur der Einstieg sein, letztlich kommt es darauf an, die Data-Analytics-Werkzeuge im Alltag auszuprobieren und anzuwenden.

Das Projektteam, bestehend aus dem Application Management der ENGIE Deutschland, ist inzwischen in der Lage, mit Data-Analytics-Werkzeugen auftretende Fragestellungen zu bearbeiten.

Sie sind ebenfalls daran interessiert, die Datenimplementierung und -analyse Ihres Unternehmens voranzutreiben? Dann kommen Sie gern jederzeit auf uns zu!